抓取预算是指搜索引擎想要在您的网站上抓取多快和多少页。它受爬虫想在您的网站上使用的资源量和您的服务器支持的爬行量的影响。

更多的抓取并不意味着你会有更好的排名,但如果你的网页没有被抓取和索引,它们根本就不会有排名。

大多数网站不需要担心抓取预算,但在少数情况下,你可能要看一下。让我们来看看其中的一些情况。

对于较新的网站来说,抓取预算可能是一个问题,特别是那些有很多网页的网站。你的服务器可能能够支持更多的抓取,但是由于你的网站是新的,而且很可能还不是很受欢迎,所以一个 搜索引擎 可能不怎么想抓取你的网站。这主要是期望值上的脱节。你希望你的网页被抓取和索引,但谷歌不知道是否值得索引你的网页,而且可能不想抓取你希望他们抓取的那么多网页。

对于拥有数百万页的大型网站或经常更新的网站来说,抓取预算也可能是一个问题。一般来说,如果你有很多页面没有被抓取或没有像你希望的那样经常更新,那么你可能想考虑加快抓取速度。我们将在文章后面谈一谈如何做到这一点。

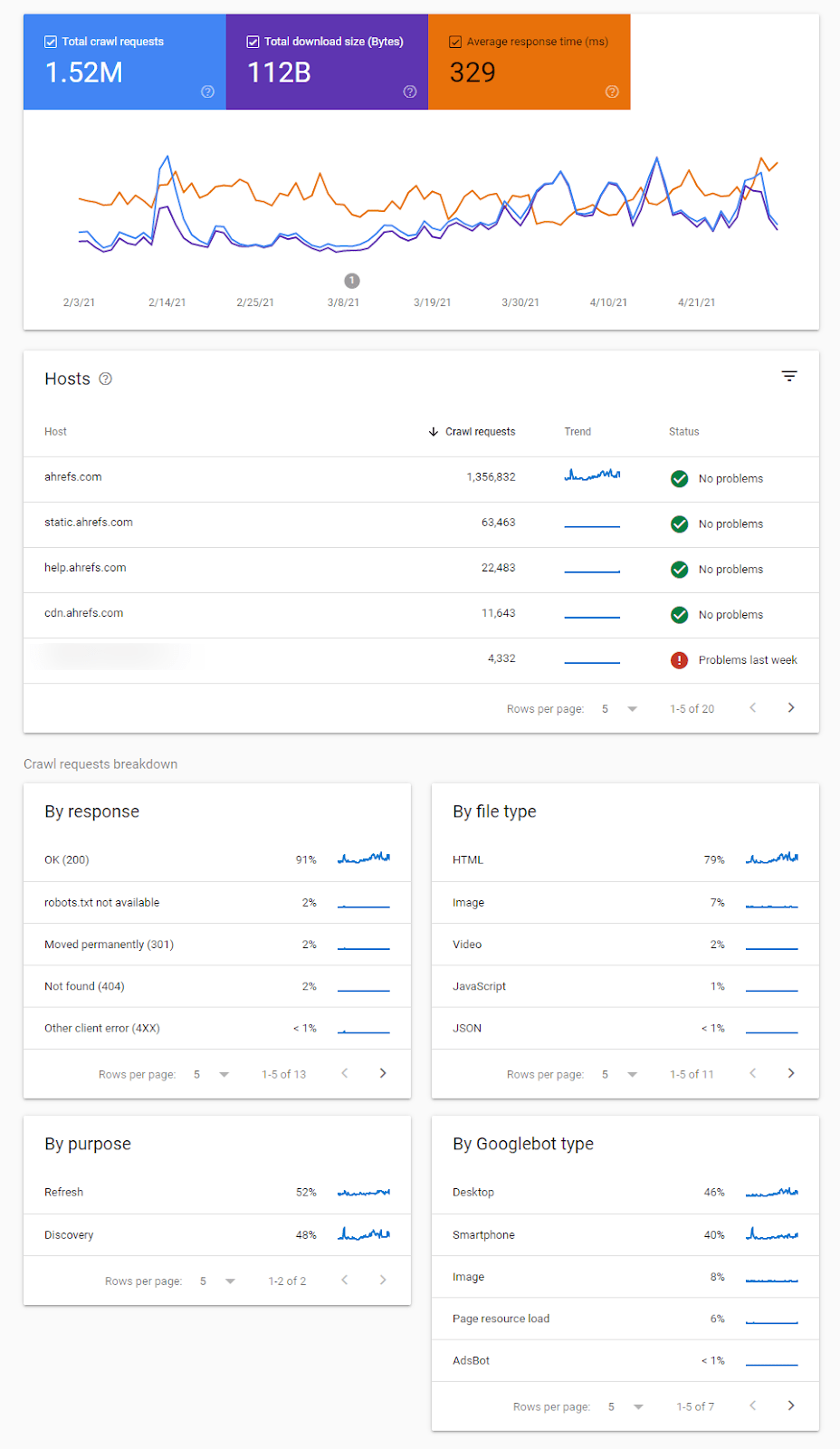

这里有各种报告,可以帮助你识别抓取行为的变化,抓取的问题,并给你提供更多关于谷歌如何抓取你的网站的信息。

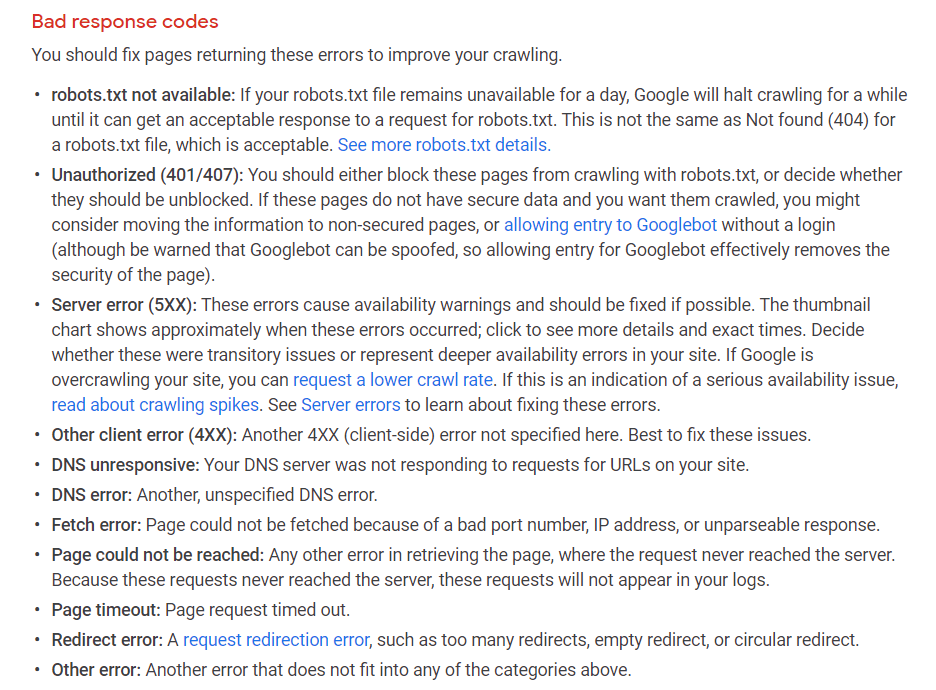

你肯定想研究一下任何 标记的爬行状态 像这里显示的那些。

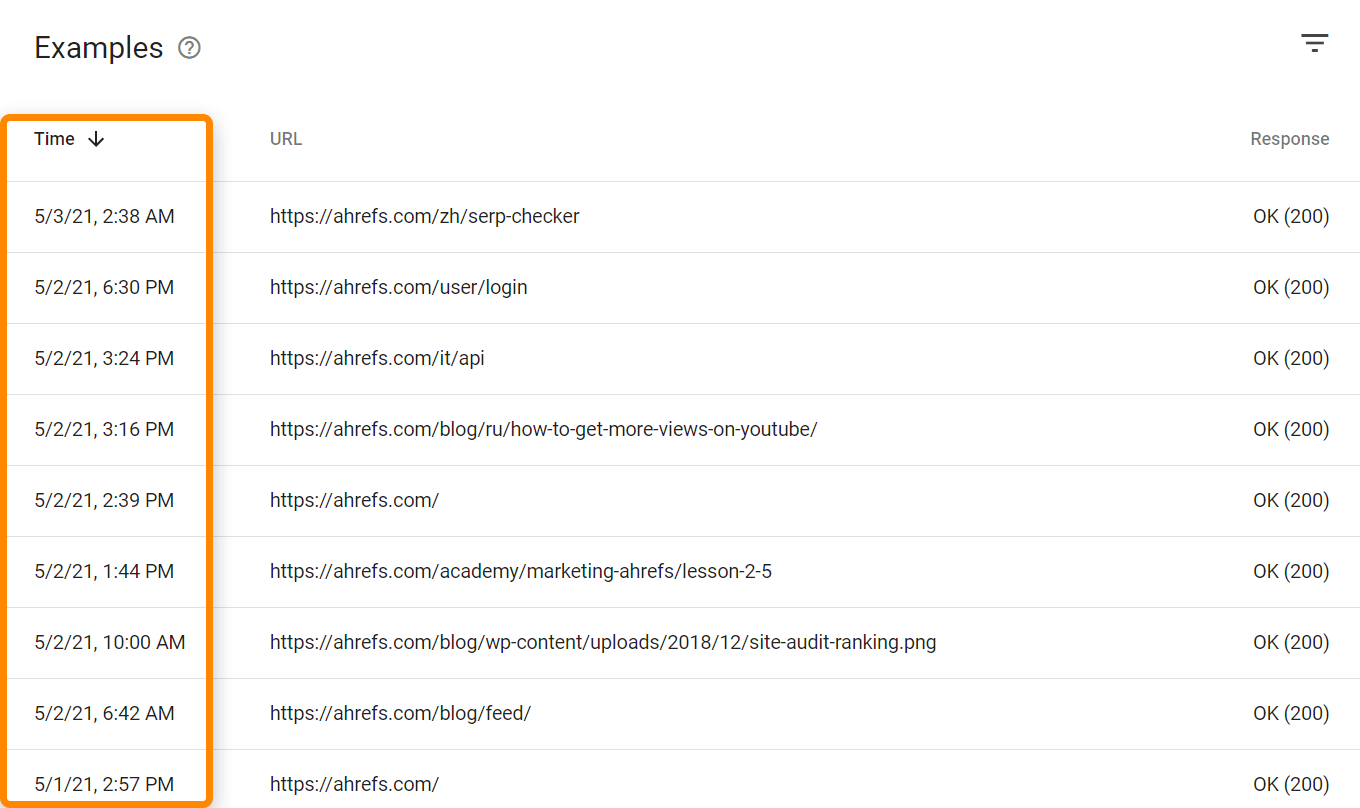

还有最后一次抓取网页的时间戳。

如果你想看到来自所有机器人和用户的点击,你需要访问你的日志文件。根据主机和设置的不同,你可能有机会使用像Awstats和Webalizer这样的工具,就像在带有cPanel的共享主机上看到的那样。这些工具显示了一些来自你的日志文件的汇总数据。

对于更复杂的设置,你将不得不访问和存储来自原始日志文件的数据,可能来自多个来源。对于大型项目,你可能还需要专门的工具,如 ELK (elasticsearch, logstash, kibana)堆栈,可以对日志文件进行存储、处理和可视化。还有一些日志分析工具,如 Splunk.

这些URL可以通过抓取和解析页面,或从包括网站地图在内的各种其他来源找到。 RSS 馈送,在谷歌搜索控制台提交URL进行索引,或使用 索引 API.

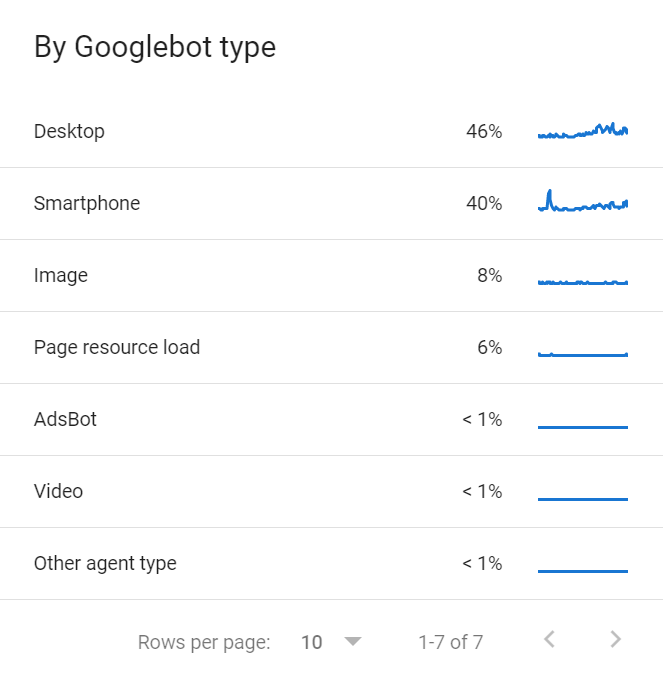

也有 多个Googlebots 共享抓取预算。您可以在 “抓取统计 “报告中找到抓取您网站的各种谷歌机器人的清单。 GSC.

抓取需求

抓取需求只是谷歌想在你的网站上抓取多少内容。更受欢迎的页面和经历重大变化的页面将被抓取更多。

受欢迎的网页,或那些有更多链接的网页,通常会比其他网页获得优先权。记住,谷歌必须以某种方式对你的网页进行优先抓取,而链接是确定你网站上哪些网页更受欢迎的一个简单方法。不过,这不仅仅是你的网站,而是互联网上所有网站的所有页面,谷歌必须弄清楚如何进行优先排序。

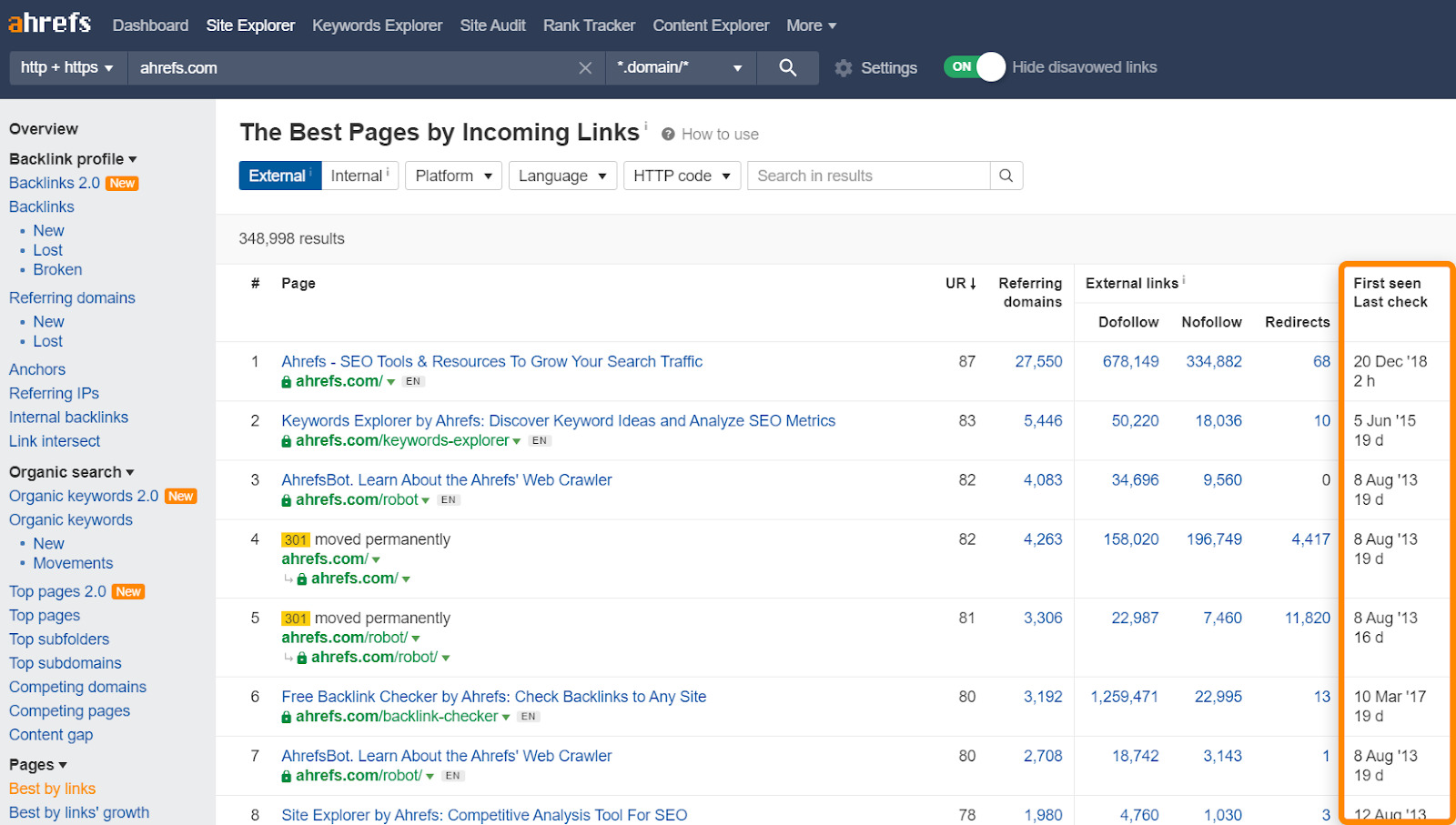

你可以使用 最佳链接 报告在 网站浏览器 作为哪些页面可能被更频繁地抓取的指示。它还显示了Ahrefs最后一次抓取您的网页的时间。

还有一个呆板性的概念。如果谷歌看到一个页面没有变化,他们会减少抓取该页面的频率。例如,如果他们抓取一个页面,并在一天后看到没有变化,他们可能会等三天再抓取,下次等十天,30天,100天,等等。他们在两次抓取之间没有实际的固定期限,但随着时间的推移,它将变得越来越不频繁。然而,如果谷歌看到网站整体上的巨大变化或网站的移动,他们通常会提高抓取率,至少是暂时的。

抓取率限制

抓取率限制是指您的网站能够支持多少抓取。网站在出现服务器稳定性问题(如速度减慢或错误)之前,可以承受一定的爬行量。如果爬虫开始看到这些问题,大多数爬虫会放弃爬行,以免损害网站。

谷歌将根据网站的抓取健康状况进行调整。如果该网站在更多的抓取下没有问题,那么限制就会增加。如果网站有问题,那么谷歌将放慢他们的抓取速度。

加快您的服务器速度/增加资源

谷歌抓取网页的方式基本上是下载资源,然后在他们的终端进行处理。你的 页面速度 与用户所感知的不太一样。影响抓取预算的是谷歌连接和下载资源的速度,这与服务器和资源有较大关系。

更多的链接,外部+内部

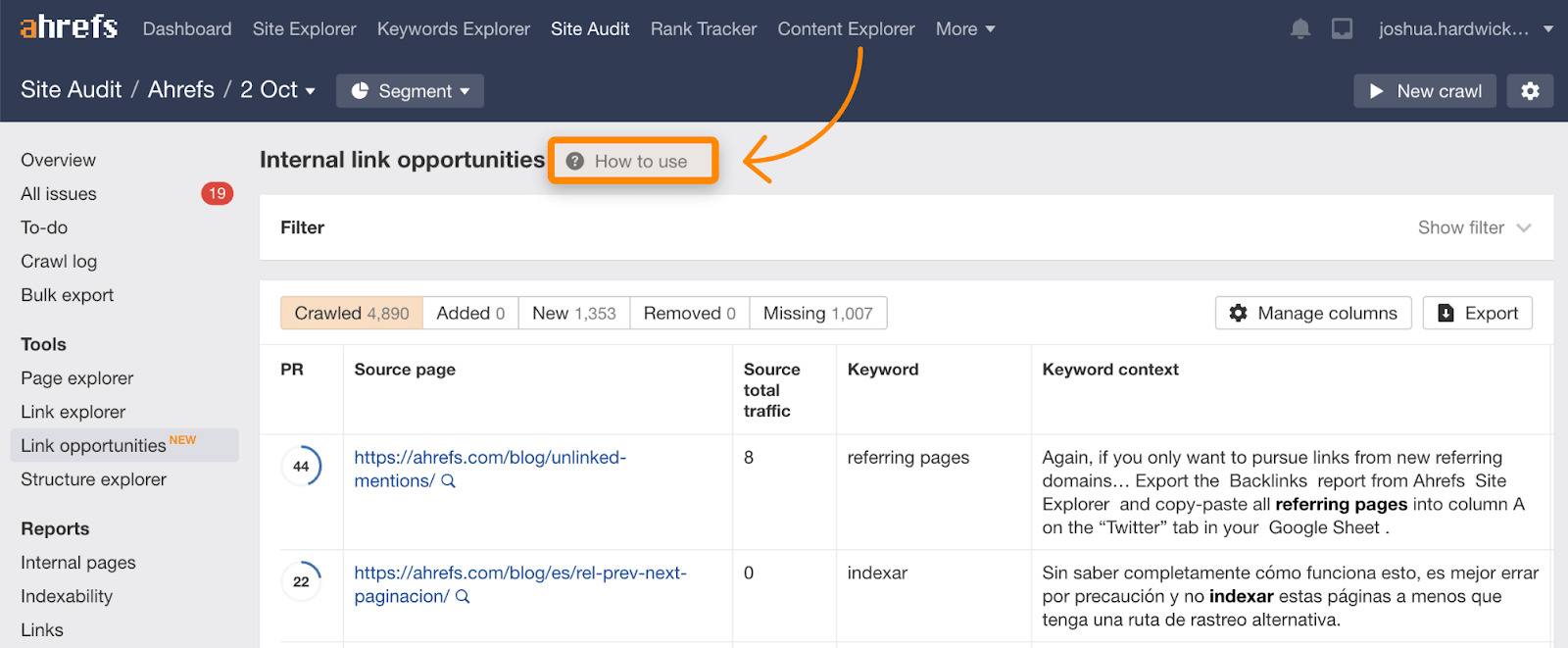

记住,抓取需求一般是基于人气或链接。你可以通过增加你的预算来增加 外部链接 和/或 内部链接.内部链接比较容易,因为你控制着网站。你可以在以下网站上找到建议的内部链接 链接机会 报告在 网站审计,其中还包括一个解释其如何工作的教程。

修复破损和重定向的链接

保持您网站上破损或重定向页面的链接处于活动状态,将对抓取预算产生小的影响。通常情况下,这里链接的页面的优先级会相当低,因为它们可能已经有一段时间没有变化了,但是清理任何问题都有利于网站的总体维护,并会对您的抓取预算有一些帮助。

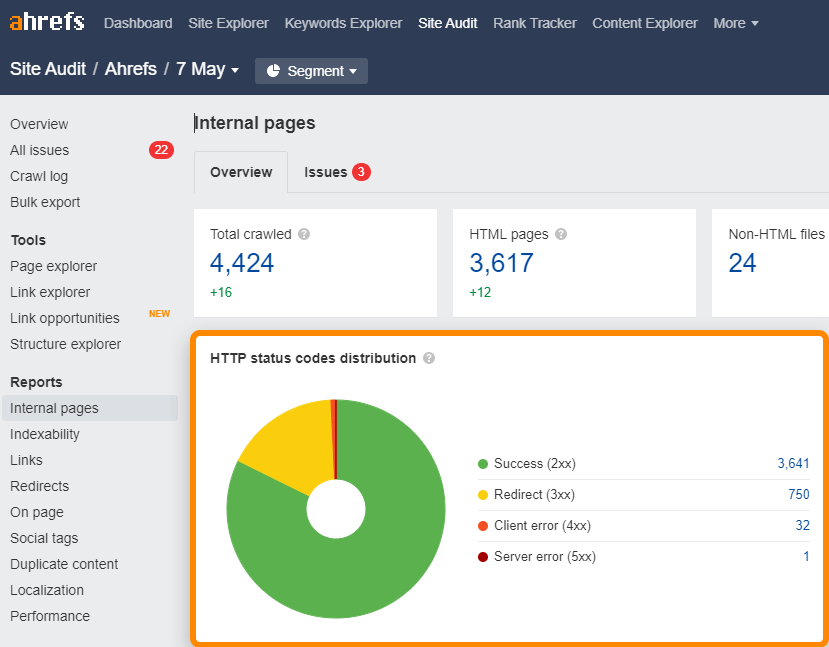

你可以在 “网站 “中很容易地找到你网站上被破坏的(4xx)和重定向的(3xx)链接。 内部页面 在网站审计中报告。

对于网站地图中的破碎或重定向链接,请检查 所有问题 为””报告3XX 网站地图中的重定向 “和”4XX page in sitemap “的问题。

使用 获取 而不是 邮政 在这里你可以

这个问题的技术性更强一些,因为它涉及到 HTTP 请求方法。不要使用 POST 请求,其中 GET 请求工作。这基本上是 GET (拉)对 帖文 (推)。 邮政 请求没有被缓存,所以它们确实会影响抓取预算,但 GET 请求可以被缓存。

使用索引 API

如果你需要更快地抓取网页,请检查你是否有资格获得谷歌的 索引 API.目前,这只适用于少数用例,如招聘信息或实时视频。

必应也有一个 编制索引 API 这对每个人都是可用的。

哪些东西不能用

有几件事人们有时会尝试,但实际上对你的爬行预算没有帮助。

- 对网站的小改动。 在页面上做小改动,如更新日期、空格或标点符号,希望让页面更频繁地被抓取。谷歌非常善于判断变化是否重要,所以这些小变化不可能对抓取产生任何影响。

- robots.txt中的Crawl-delay指令。 这个指令将减慢许多机器人的速度。但是Googlebot不使用它,所以它不会产生影响。我们在Ahrefs尊重这一点,所以如果您需要减慢我们的抓取速度,您可以在您的 robots.txt 文件。

- 删除第三方脚本。 第三方脚本不计入你的抓取预算,所以删除它们不会有任何帮助。

- Nofollow。 好吧,这一次是不确定的。在过去 无ollow链接 就不会使用抓取预算。然而,nofollow现在被当作一种提示,所以谷歌可能会选择抓取这些链接。

调整速度慢,但有保证

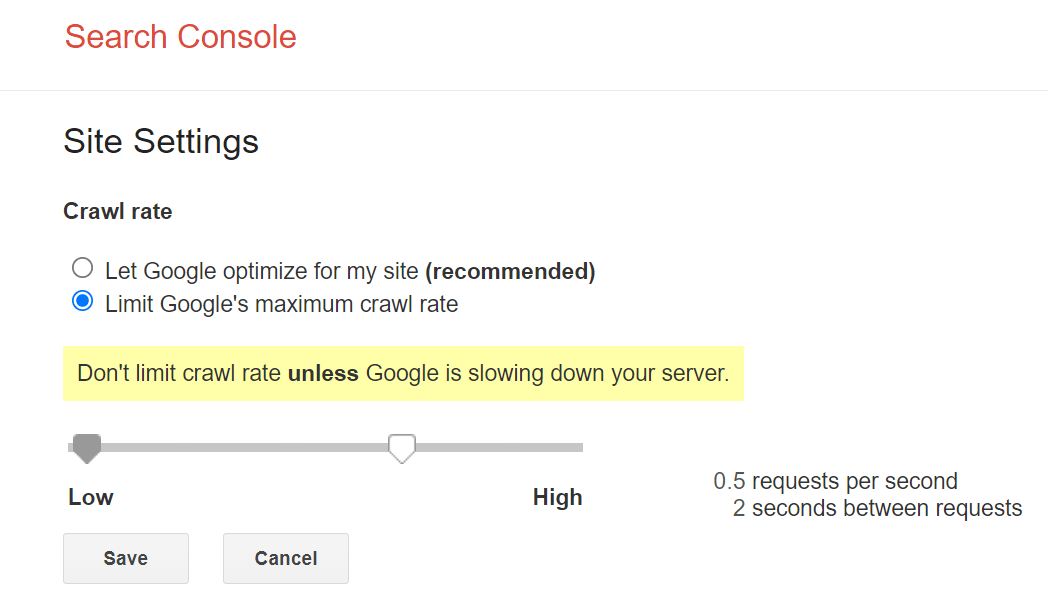

谷歌给我们提供的爬行速度较慢的主要控制是一个 速率限制器 在谷歌搜索控制台内。你可以用该工具减慢抓取率,但它可能需要两天时间才能生效。

快速调整,但有风险

如果你需要一个更直接的解决方案,你可以利用谷歌与你的网站健康有关的爬行速率调整。如果你在页面上为Googlebot提供’503服务不可用’或’429请求过多’的状态代码,它们将开始爬行得更慢,或者可能暂时停止爬行。不过,你不希望这样做的时间超过几天,否则他们可能开始从索引中删除页面。

最后

再次重申,对于大多数人来说,爬行预算并不是需要担心的问题。如果你确实有顾虑,我希望这个指南是有用的。

我通常只在以下情况下才会研究这个问题:有网页没有被抓取和索引的问题,我需要解释为什么有人不应该担心这个问题,或者我碰巧在Google Search Console的抓取统计报告中看到一些让我担心的东西。